Python数据分析入门知识图谱(中篇) 数据分析与处理核心索引

在掌握了Python数据分析的基础环境与数据结构(上篇)后,我们进入知识体系的核心阶段——数据分析与处理。本篇将作为您深入数据分析领域的“索引”与“地图”,系统梳理从数据清洗到初步分析的关键知识与技能模块。

一、数据清洗与预处理:分析的基石

数据分析的绝大部分价值,源于对“脏数据”的净化与规整。此阶段是保证后续分析结果可靠性的关键。

- 处理缺失值:识别(

isna(),isnull())、决策(删除dropna或填充fillna)与高级填充技巧(均值、中位数、前后向填充或模型预测)。 - 处理异常值:通过描述性统计(

describe())、可视化(箱线图)识别,并运用分位数法、标准差法(3σ原则)进行检测与处理(盖帽、分箱或删除)。 - 数据转换:

- 类型转换:

astype()函数确保数据类型(如日期、分类)正确。

- 重复值处理:

duplicated()检测,drop_duplicates()删除。

- 字符串处理:利用

.str访问器进行大小写转换、分割、替换与正则表达式匹配。

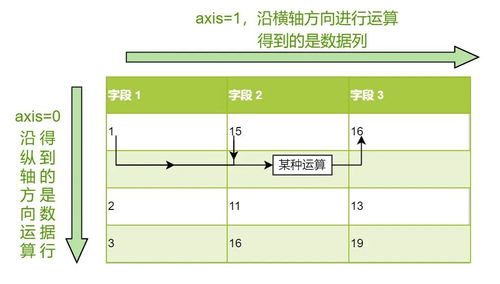

二、数据整合与重塑:连接多维信息

现实数据常分散于多个来源,整合是构建分析视图的必要步骤。

- 数据合并:

pd.concat:沿轴(行或列)简单堆叠数据。

pd.merge/df.join:基于一个或多个键,像SQL连接一样横向合并数据集,需掌握内连接、左连接、右连接和外连接的区别与应用场景。

- 数据重塑:

- 透视表:

pivot_table是强大的多维分组聚合工具,可快速生成交叉表,进行多维度分析。

- 融合与旋转:了解

melt(列转行)与pivot(行转列)在数据形态转换中的作用。

三、数据转换与特征工程:为模型准备食材

此步骤旨在从原始数据中提炼出对分析目标更有意义的信息。

- 应用函数:使用

apply()、map()或向量化操作对序列或 DataFrame 进行自定义转换。 - 分组聚合:GroupBy操作是核心中的核心。理解“拆分-应用-合并”范式,熟练使用

groupby()结合聚合函数(sum,mean,count,agg)、转换(transform)与过滤(filter)。 - 创建新特征:

- 分箱/离散化:

pd.cut/pd.qcut将连续数据转化为分类数据。

- 哑变量/独热编码:

pd.get_dummies将分类变量转换为机器学习模型可理解的数值格式。

- 日期时间特征:从日期时间列中提取年、月、日、星期、小时等。

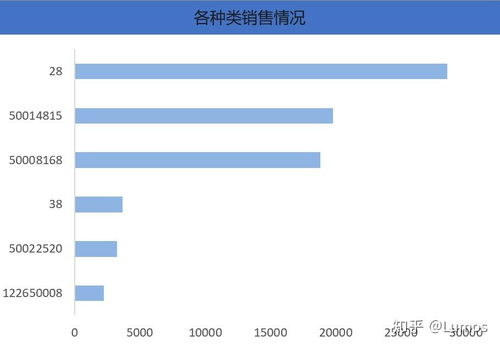

四、描述性统计与初步探索:发现数据的故事

在深入建模前,必须用统计眼光审视数据全貌。

- 集中趋势与离散程度:计算均值、中位数、众数、标准差、方差、分位数等(

mean,median,mode,std,var,quantile)。 - 数据分布与关系:

- 使用

corr()计算变量间的相关系数(皮尔逊、斯皮尔曼)。

- 通过协方差矩阵考察变量协同变化趋势。

- 探索性数据分析(EDA):

- 可视化辅助:虽然深度可视化是下篇内容,但此处应结合直方图(看分布)、散点图(看关系)、箱线图(看异常与分布)进行初步探索。

- 摘要报告:可使用

pandas_profiling(现为ydata-profiling)库一键生成详尽的数据概况报告。

五、核心工具与函数索引

- Pandas核心:

DataFrame/Series对象方法、索引与切片(loc,iloc)、查询(query)。 - 处理类:

fillna,dropna,drop_duplicates,replace,astype。 - 整合类:

concat,merge,join,pivot_table,melt。 - 转换聚合类:

groupby,agg,apply,transform,map,pd.cut。 - 统计类:

describe,mean,sum,count,std,corr,cov。

从处理到洞察

本篇构建的“数据分析与处理”知识模块,是连接原始数据与高级分析(机器学习、深度可视化、统计推断)的桥梁。熟练运用这些技术,意味着您能将杂乱无章的数据转化为整洁、有信息量的数据集,为揭示数据背后的模式、趋势与洞见打下坚实基础。请务必在实战项目中反复练习,尤其是GroupBy操作与数据清洗流程。在下一篇(下篇)中,我们将聚焦于高级可视化、统计分析与初步的机器学习模型应用,完成数据分析入门知识图谱的最后拼图。

如若转载,请注明出处:http://www.iata-boms.com/product/66.html

更新时间:2026-02-28 05:50:31